Ansys – auf dem Weg zur künstlichen Intelligenz?

In „Matrix“ lebt Neo in einer virtuellen Welt. Löffel lassen sich verbiegen und physikalische Grenzen überschreiten. Ok - so weit sind wir noch nicht, aber der schnelle Fortschritt physikbasierter Simulation prophezeit, dass wir in naher Zukunft unglaubliche Dinge machen können. Tauchen wir in eine „Vorwelt“ ein, in welcher Ihnen ein trainiertes System in Echtzeit „den Löffel verbiegt“.

Workflows in Ansys – Analogien zur künstlichen Intelligenz

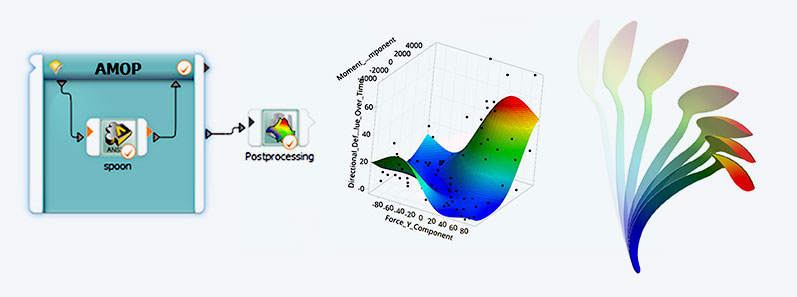

Beginnen wir mit einer Einordnung. Ähnlich wie bei einer KI wie ChatGPT hängt die Qualität der Prognose eines Simulationsmodells maßgeblich von einer sauberen Datenbasis ab, welche es gilt im Anschluss zu trainieren. Wir als Ingenieure haben jedoch keine Big Data mit Milliarden von Stellschrauben. Für uns bilden im schlimmsten Fall ein paar 100 Variantenstudien unseres Designs sowie deren Berechnung des physikalischen Verhaltens die Datenbasis. Das ist im Vergleich dann doch gut überschaubar. In unserem Fall verbiegen und tordieren wir unseren Löffel mittels Parameter in alle möglichen Richtungen. Das ist sehr einfach: es ist nur ein Klick ins Parameterkästchen, und schon lassen sich die Werte über den Parametersatz ändern (siehe Bild unten).

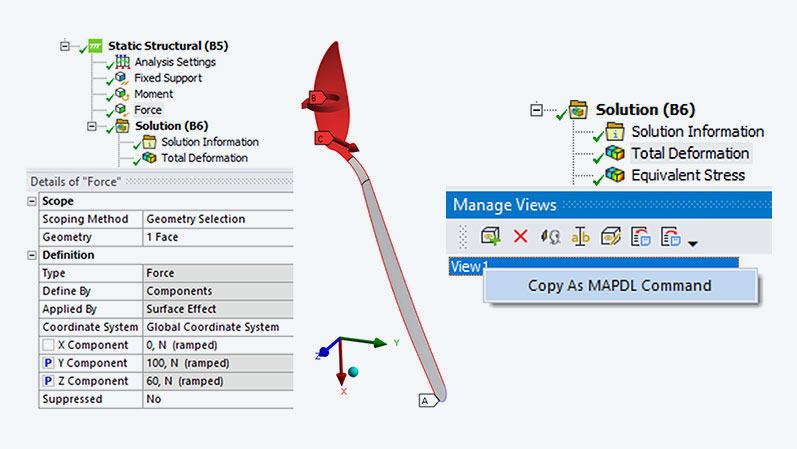

Die Datenbasis entsteht nun, wenn wir mittels dieser Parameter Varianten erzeugen und berechnen. Ein Blick auf die entstandenen Werte der max. Verformung ist zunächst schwer zu interpretieren. Helfen können jedoch bereits Bilder. Wussten Sie, dass Sie für jede Variante ein zusätzliches Bild wegspeichern können? Das können Sie z.B. mit APDL machen:

Die Informationen der Wunschansicht bekommen Sie über den View Manager (siehe Bild unten). Erstellen Sie eine Ansicht und kopieren Sie sich den APDL Code mit der rechten Maustaste weg. Mit dem optiSLang Data Send Knoten können Sie am Ende festlegen, dass diese Bilder nicht gelöscht werden.

Oder verwenden Sie ein „After Post“ Python Code Snippet:

import os

solveDir = solution.WorkingDir

camera = Graphics.Camera

camera.SetSpecificViewOrientation(ViewOrientationType.Bottom)

camera.SetFit()

viewOptsRes = Graphics.ViewOptions.ResultPreference

viewOptsRes.ContourView = MechanicalEnums.Graphics.ContourView.ContourBands

viewOptsRes.ExtraModelDisplay = MechanicalEnums.Graphics.ExtraModelDisplay.UndeformedWireframe

or myResult in solution.GetChildren(DataModelObjectCategory.Result, False):

fpath = os.path.join(solveDir,myResult.Name + ".jpg")

myResult.Activate()

Graphics.ExportImage(fpath, GraphicsImageExportFormat.JPG)

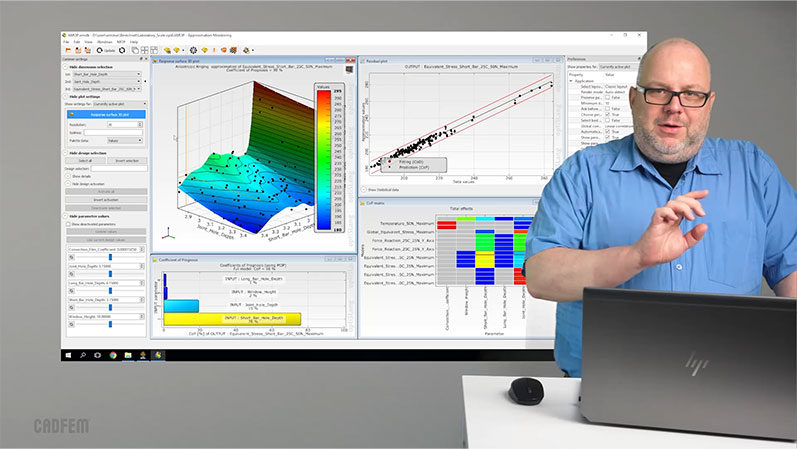

Was ist wichtig bei einem trainierten Datenmodell (DL) ?

Mit diesen Daten können wir als nächstes - nennen wir es die Deep Learning Phase - ein Metamodell trainieren, welches uns schließlich alle denkbaren auftretenden maximalen Verformungen voraussagt. Ist die Verformung der Löffelspitze größer, wenn ich den Löffel zur Seite drücke oder mit gleicher Kraft nach hinten drücke? Wie weit biegt er sich, wenn ich ihn gleichzeitig noch mit einem Moment tordiere? Kein Problem, wir sind bereits jetzt in der Lage, live und ohne weitere Simulation diese Antwort zu geben – dank unseres Metamodells. Dabei sind 3 Punkte wichtig:

- Datensicherheit: Wir wollen die entstandenen Daten schützen. Nichts soll ins Internet verschickt und dort verarbeitet werden, alles soll in unserer Rechenumgebung gehalten werden. Niemand sonst soll Ihr Löffelgeheimnis erfahren.

- Prognosequalität: Wie gut ist mein trainiertes Modell? Liefert es nur ein hübsches Ergebnis? Zur Einschätzung der Qualität steht uns u.a. der sogenannte Coefficient of Prognosis zur Seite, welcher uns mitteilt, ob wir das Modell schon verwenden können oder noch weitertrainieren sollten.

- Nachvollziehbarkeit: Und über welche Logik kommt eine KI zu ihrer Antwort? Auch das beschäftigt uns hier. Das Metamodell erklärt die Beziehungen der Parameter und trägt damit zum Verständnis bei der Interpretation der Ergebnisse bei. Also: Transparenz – keine Blackbox.

Können auch Metamodelle für Kurven erzeugt werden?

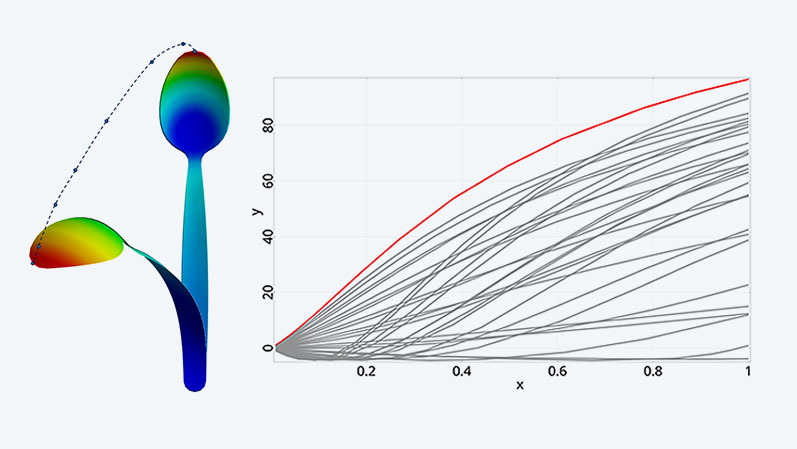

Als Betrachter des Löffels möchte ich als nächstes den Weg sehen, welchen beispielsweise die Löffelspitze zurücklegt. Also lassen Sie uns in die nächste Dimension gehen. Weg von den nicht so spannenden skalaren Werten hin zu den schon interessanteren Signalen. Dazu wird das Resultfile jeder Variante eingelesen und der Verlauf der Verschiebungskomponenten des Knotens an der Löffelspitze in sogenannte Channels gespeichert. Aus diesen können Signale erzeugt werden und ein Signal-Metamodell trainiert werden. Jetzt erkennt man den Weg, welchen die Spitze in jeder Situation zurücklegen würde.

Aber nicht nur das - auch sehen wir diejenigen Parameter, welche diesen Weg maßgeblich bestimmen. Wenn wir wissen, welche Parameter für die Kurvencharakteristik bzw. für den jeweiligen Kurvenabschnitt verantwortlich sind, so können wir diese Information nutzen, um auch nur mit diesen Parametern weiter zu arbeiten. Wir ignorieren sozusagen die unwichtigen Parameter, sparen damit Zeit und können mit diesem „Vorfilter“ sogar höhere Prognosegüten erzielen.

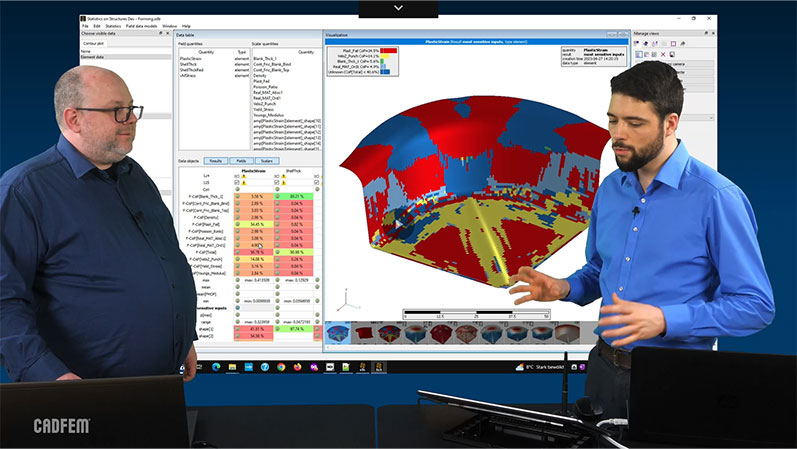

Wie trainiere ich ein Metamodell für ein Feld?

Aber wars das schon? Nein, wir wollen ja nicht nur die Löffelspitze sehen, sondern die Verschiebung einer jeden einzelnen Stelle des Löffels beschreiben können. Also ab in die nächste Dimension – ab in die Welt der sog. Zufallsfelder! Dazu trainieren wir kein Metamodell bzw. Signal-Metamodell für einzelne Knoten, sondern ein Feldmetamodell für unsere gesamte Struktur.

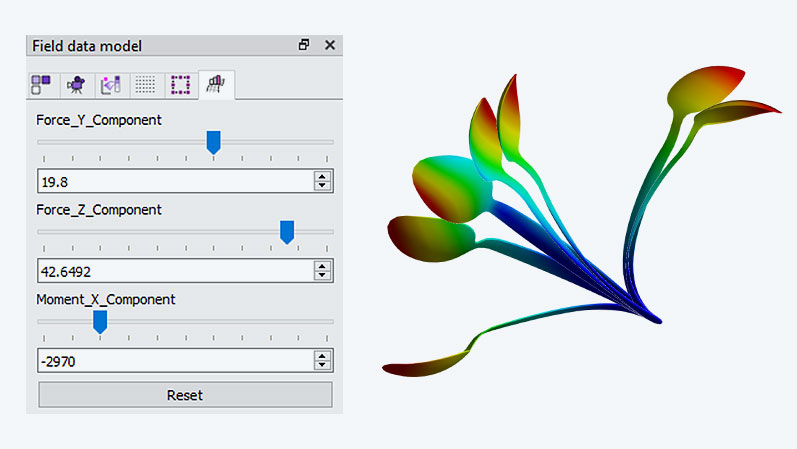

Dieses ist dann in der Lage, das komplette Verformungsverhalten des Löffels unter allen möglichen Kraft- und Momenteneinflüssen zu beschreiben – und das in Echtzeit, ebenfalls wieder ohne Simulation.

Da es sich augenscheinlich auch hier um ein Approximationsmodell handelt, stellt sich zwangsläufig erneut die Frage nach der Qualität der Verformungsfelder. Diese lässt sich direkt auf der Struktur in Form eines Farbplots darstellen, um dem ganzen nicht blind vertrauen zu müssen. Denn es ist wieder wie bei der KI – wer ihr blind vertraut, hat schon verloren. Es gilt die Dinge immer zu hinterfragen. Wir machen das dieses Mal mit einem Vergleich der Standardabweichungen der eingelesenen Zufallsfelder mit dem generierten Zufallsfeldmodell.

Wofür kann ich ein Feldmetamodell verwenden?

Und jetzt, da das nachweislich hochwertige Feldmetamodell vorliegt, kann dieses auch verwendet werden. Also Fragen stellen und Antworten betrachten. Damit das schnell gelingt, gibt es sogenannte Field Inspektoren – das sind Schieberegler für die Eingangsparameter - mit Hilfe welcher blitzschnell die Wunschwerte, sprich die Fragen, eingestellt werden können. Die Antworten kommen live in Form von Simulationsbildern.

Und das, was wir für den Löffel gemacht haben, das lässt sich mit allen in Ansys berechenbaren Feldern machen

- Spannungsfelder

- Temperaturfelder

- elektromagnetische Felder

- Strömungsfelder und vieles mehr.

Der Vorteil liegt auf der Hand: Einmal trainiert kann ich meine Fragen stellen und bekomme sofort die Antwort. Ähnlich wie bei ChatGPT spart das natürlich enorm viel Zeit.

optiSLang zur Verwendung von DL bzw. ML in Ansys

Doch stop, … was, wenn sich die Datenbasis erweitert? Sprich neue Erkenntnisse vorliegen, welche mein Modell noch schlauer machen würden? Dafür gibt es den Reevaluate Workflow und die Technologie des sogenannten Adaptive Metamodel of optimal Prognosis (kurz AMOP). So können Sie einerseits aus Ihren Datensätzen zusätzliche, anfangs scheinbar unwichtige Ergebnisgrößen nachträglich extrahieren und andererseits auch das Metamodell weiter trainieren. Dieser Predictive Analytics Ansatz lässt die Gedanken noch weiter schweifen - in Richtung integriertes Live-Feedback auf Web-Seiten, Systemsimulationen oder digitale Zwillinge. Das Tor ist geöffnet.

Treffen Sie jetzt eine Entscheidung: Sie können weitermachen wie bisher - oder aber wenn Sie nun in die tiefsten Tiefen des Kaninchenbaus tauchen wollen, so haben wir einen Plan für Sie: Beginnen Sie mit einem kostenlosen Einstieg in dieses Thema. Und beschreiten Sie dann den Weg über die CADFEM Seminar Flatrate. Dort bekommen Sie alles was Sie brauchen: Sie erarbeiten sich im eLearning für “optiSLang” die wichtigsten Kenntnisse und vertiefen diese mit CADFEM Let’s Simulate Serien zur “Verknüpfung von Prozessen” und “Statistics on Structures”. Genau das, was Sie benötigen, um das für Ihr eigenes Projekt umzusetzen! Arbeiten Sie also nicht mit Tricks bekannter Mentalisten, sondern werden Sie eins mit dem Löffel!